Поспешное внедрение новых мощных технологий генеративного ИИ, таких как ChatGPT, вызвало тревогу по поводу потенциального вреда и злоупотребления. Леденящий душу ответ закона на такие угрозы вызвал требования к компаниям, разрабатывающим эти технологии, внедрять ИИ «этично».

Но что, собственно, это значит?

Прямым ответом будет согласование деятельности компании с одним или несколькими из десятков наборов этических принципов ИИ, разработанных правительствами, группами заинтересованных сторон и учёными. Но это легче сказать, чем сделать.

Мы и наши коллеги провели два года, проводя интервью и опросы профессионалов в области этики ИИ в различных отраслях, чтобы понять, как они пытаются достичь этического ИИ — и что они могут упустить. Мы узнали, что соблюдение этики ИИ на практике заключается не столько в переносе этических принципов на корпоративные действия, сколько в реализации управленческих структур и процессов, которые позволяют организации выявлять и смягчать угрозы.

Это, вероятно, будет разочаровывающей новостью для организаций, которые ищут однозначное руководство, позволяющее избежать серых зон, и для потребителей, надеющихся на четкие и защитные стандарты. Но это указывает на лучшее понимание того, как компании могут реализовывать этический ИИ.

Борьба с этической неопределенностью

Наше исследование, которое послужит основой для готовящейся книги, было сосредоточено на тех, кто отвечает за управление вопросами этики ИИ в крупных компаниях, использующих ИИ. С конца 2017 по начало 2019 года мы взяли интервью у 23 таких руководителей. Их должности варьировались от ответственного за конфиденциальность и юрисконсульта по вопросам конфиденциальности до новой на тот момент, но всё более распространённой сегодня должности: ответственный за этику данных. Наши беседы с этими руководителями по этике ИИ позволили сделать четыре основных вывода.

Во-первых, наряду с многочисленными преимуществами, использование ИИ в бизнесе сопряжено с существенными рисками, и компании знают об этом. Менеджеры по этике ИИ выразили обеспокоенность по поводу конфиденциальности, манипуляций, предвзятости, непрозрачности, неравенства и вытеснения рабочей силы. В одном известном примере Amazon разработал ИИ-инструмент для сортировки резюме и обучил его находить кандидатов, похожих на тех, кого он нанимал в прошлом. Доминирование мужчин в технологической индустрии означало, что большинство сотрудников Amazon были мужчинами. Соответственно, инструмент научился отвергать кандидатов-женщин. Не сумев решить эту проблему, Amazon в итоге был вынужден отказаться от проекта.

Генеративный ИИ вызывает дополнительные опасения по поводу дезинформации и языка вражды в больших масштабах, а также незаконного присвоения интеллектуальной собственности.

Во-вторых, компании, которые стремятся к этичному ИИ, делают это в основном по стратегическим причинам. Они хотят поддерживать доверие среди клиентов, деловых партнеров и сотрудников. И они хотят упредить или подготовиться к появляющимся нормативным актам. Скандал между Facebook и Cambridge Analytica, в котором Cambridge Analytica использовала данные пользователей Facebook, предоставленные без их согласия, чтобы сделать вывод о психологических типах пользователей и направить на них манипулятивную политическую рекламу, показал, что неэтичное использование передовой аналитики может подорвать репутацию компании или даже, как в случае с Cambridge Analytica, привести к её краху. Компании, с которыми мы разговаривали, хотели, чтобы их воспринимали как ответственных распорядителей данных людей.

Проблема, с которой столкнулись менеджеры по этике ИИ, заключалась в том, чтобы понять, как лучше всего достичь «этичного ИИ». В первую очередь они обратились к принципам этики ИИ, особенно к тем, которые уходят корнями в биоэтику или принципы прав человека, но сочли их недостаточными. Дело было не только в том, что существует множество конкурирующих наборов принципов. Дело было в том, что справедливость, честность, благодеяние, автономия и другие подобные принципы являются спорными, подлежат интерпретации и могут противоречить друг другу.

Это привело нас к третьему выводу: Менеджерам нужно нечто большее, чем высокоуровневые принципы ИИ, чтобы решить, что делать в конкретных ситуациях. Один менеджер по этике ИИ рассказал о попытке перевести принципы прав человека в набор вопросов, которые разработчики могли бы задавать себе для создания более этичных программных систем ИИ. «Мы остановились после 34 страниц вопросов», — сказал менеджер.

В-четвертых, профессионалы, сталкивающиеся с этической неопределенностью, обращались к организационным структурам и процедурам, чтобы вынести решение о том, что делать. Некоторые из них были явно неадекватны. Но другие, пока еще в значительной степени находящиеся в стадии разработки, оказались более полезными, например:

Найм сотрудника по этике ИИ для создания программы и надзора за ней.

Создание внутреннего комитета по этике ИИ для взвешивания и решения трудных вопросов.

Составление контрольных списков по этике данных и требование от специалистов по анализу данных, работающих в первых рядах, заполнять их.

Обращение к учёным, бывшим регуляторам и защитникам для получения альтернативных точек зрения.

Проведение оценок влияния алгоритмов по типу тех, которые уже используются в управлении экологией и конфиденциальностью.

Этика как ответственное принятие решений

Ключевая идея, которая возникла в результате нашего исследования, заключается в следующем: Компании, стремящиеся использовать ИИ этично, не должны ожидать открытия простого набора принципов, дающих правильные ответы со всезнающей, божьей точки зрения. Вместо этого им следует сосредоточиться на очень человеческой задаче — попытке принимать ответственные решения в мире ограниченного понимания и меняющихся обстоятельств, даже если некоторые решения в итоге окажутся несовершенными.

В отсутствие явных законодательных требований компании, как и отдельные люди, могут лишь делать всё возможное, чтобы осознавать, как ИИ влияет на людей и окружающую среду, и быть в курсе общественных проблем и последних исследований и экспертных идей. Они также могут обратиться к большому и разнообразному кругу заинтересованных сторон и серьезно заняться этическими принципами высокого уровня.

Эта простая идея меняет разговор в важных направлениях. Она побуждает специалистов по этике ИИ направить свою энергию не столько на выявление и применение принципов ИИ — хотя они остаются частью истории, — сколько на принятие структур и процессов принятия решений, обеспечивающих учет воздействия, точек зрения и общественных ожиданий, которые должны лежать в основе их бизнес-решений.

В конечном итоге, мы считаем, что законы и нормативные акты должны будут обеспечить существенные ориентиры для организаций, к которым они должны стремиться. Но структуры и процессы ответственного принятия решений — это место, с которого можно начать, и со временем они должны помочь накопить знания, необходимые для разработки защитных и работоспособных материальных правовых стандартов.

Действительно, в развивающемся законодательстве и политике ИИ основное внимание уделяется процессу. В Нью-Йорке был принят закон, требующий от компаний проводить аудит своих систем ИИ на предмет вредных предубеждений, прежде чем использовать эти системы для принятия решений о найме на работу. Члены Конгресса внесли законопроекты, которые потребуют от компаний проводить оценку влияния алгоритмов перед использованием ИИ для принятия решений о кредитовании, трудоустройстве, страховании и других подобных важных решений. Эти законы делают акцент на процессах, которые заранее учитывают многочисленные угрозы ИИ.

Некоторые разработчики генеративного ИИ придерживаются совершенно иного подхода. Сэм Альтман, генеральный директор OpenAI, изначально объяснял, что, выпуская ChatGPT в открытый доступ, компания стремилась дать чатботу «достаточно воздействия реального мира, чтобы ты обнаружил некоторые случаи неправильного использования, о которых ты бы не подумал, чтобы ты мог создать лучшие инструменты». На наш взгляд, это не ответственный ИИ. Это отношение к людям как к морским свинкам в рискованном эксперименте.

Призыв Альтмана на слушаниях в Сенате в мае 2023 года к государственному регулированию ИИ показывает большее осознание проблемы. Но мы считаем, что он заходит слишком далеко, перекладывая на правительство ответственность, которую также должны нести разработчики генеративного ИИ. Сохранение общественного доверия и предотвращение вреда для общества потребует от компаний более полного признания своей ответственности.

Исследование Пирса Тернера по этике данных было частично профинансировано грантом от Facebook и Института риска при Фишерском колледже бизнеса.

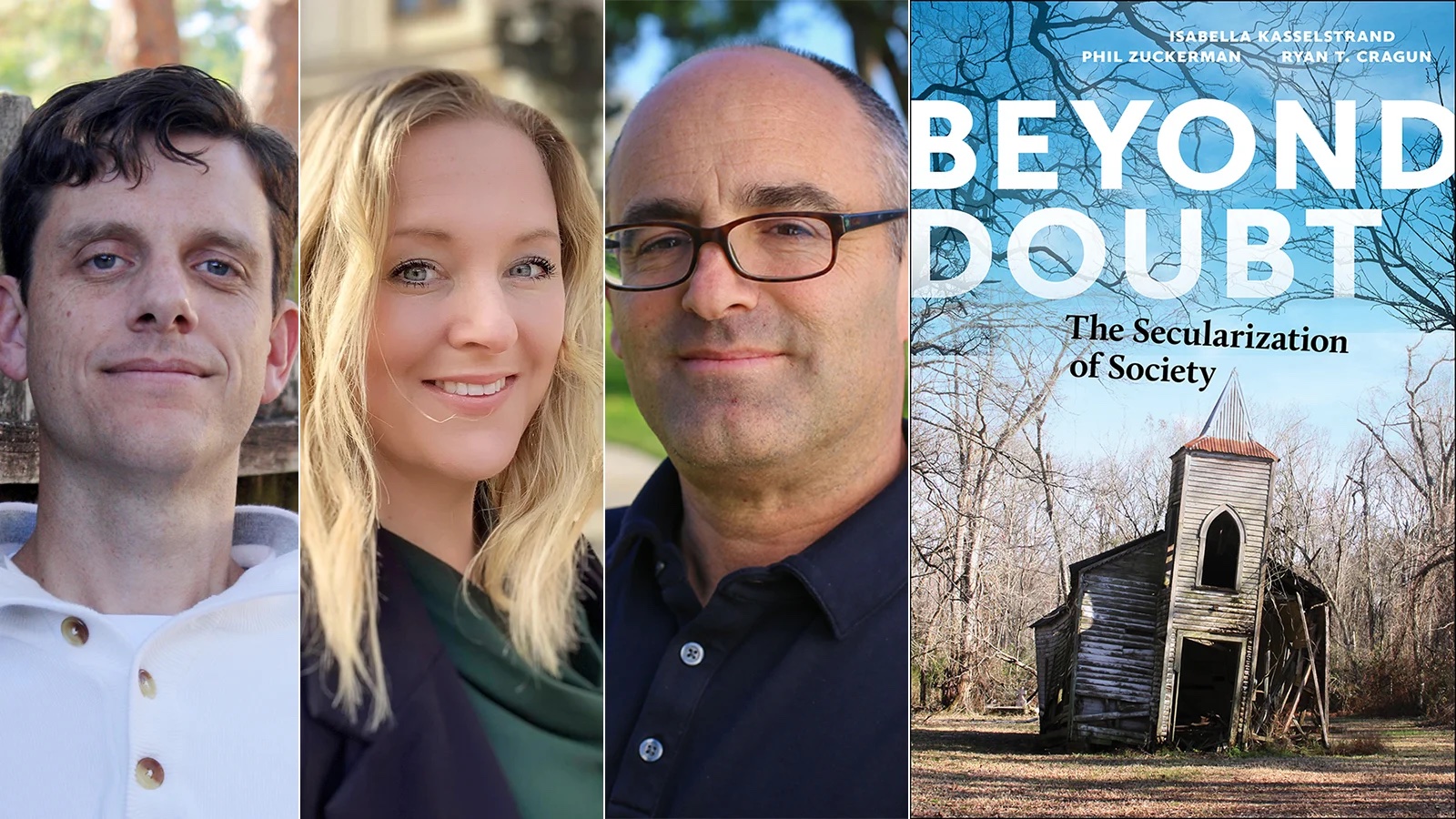

Деннис Хирш,

профессор права и компьютерных наук; директор Программы по данным и управлению; основной факультет TDAI, Государственный университет Огайо. Пирс Норрис Тернер, доцент философии и координатор программы PPE; директор Центра этики и человеческих ценностей, Государственный университет Огайо.